Copilot e Segurança de Dados: Definir Limites para a IA no Local de Trabalho

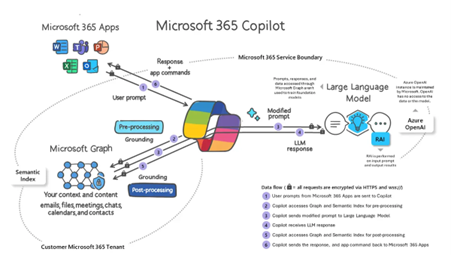

O Microsoft Copilot está rapidamente a tornar-se uma peça indispensável no local de trabalho digital moderno. Ao integrar IA em ferramentas como o Word, Excel, Teams e Outlook, o Copilot ajuda a agilizar a comunicação, automatizar tarefas repetitivas e desbloquear a produtividade como nunca antes. Mas, com grande poder vem uma grande responsabilidade — e no que diz respeito à segurança dos dados, o Copilot não é o seu guarda de segurança.

Demasiadas vezes, as organizações ativam ferramentas de IA sem implementar salvaguardas adequadas. Ao contrário de um assistente humano que sabe o que está fora dos limites, o Copilot age com base nos dados e permissões que lhe são concedidos — a menos que o restrinja explicitamente. Sem uma boa governação, isto abre a porta à exposição não autorizada de dados, violações de conformidade e ameaças internas.

A boa notícia? Pode ativar o Copilot de forma segura — se adotar uma abordagem em camadas, do lado do servidor. Aqui está como manter o seu assistente inteligente, mas seguro.

1. Microsoft Purview: Classifique e Proteja os Seus Dados

Pense no Microsoft Purview como o seu “firewall” de conteúdo. Antes de se preocupar com quem acede ao quê, assegure-se de que os seus dados estão corretamente etiquetados e governados.

Etiquetas de Sensibilidade:

Use o Purview para aplicar etiquetas que classificam o conteúdo conforme o seu nível de confidencialidade — Público, Interno, Confidencial ou Altamente Confidencial.

- Aplique etiquetas automaticamente com base em varrimento de conteúdo (por exemplo, deteção de dados financeiros, identificadores pessoais ou termos legais).

- Encripte documentos ou e-mails com políticas que restringem o acesso — mesmo dentro da sua organização.

- Impeça que o Copilot interaja com documentos classificados como “Altamente Confidenciais”.

Prevenção contra Perda de Dados (DLP):

As políticas DLP aplicam regras em tempo real. Por exemplo:

- Bloquear respostas do Copilot que possam conter informações protegidas.

- Avisar os utilizadores antes de partilharem dados sensíveis.

- Registar e reportar potenciais violações de políticas.

Melhor Prática: Combine etiquetagem automática com DLP para garantir que dados sensíveis nunca chegam ao Copilot sem controlo.

2. Azure AD & Microsoft Graph: Restrinja o que o Copilot Pode Ver

O Copilot usa o Microsoft Graph para obter dados de serviços como o Outlook, Teams, OneDrive e SharePoint. Isso significa que herda as permissões do utilizador — e opera dentro dos limites definidos no Azure AD.

Controlo de Acesso Baseado em Funções (RBAC):

Crie funções claras para evitar contas com permissões em excesso. Por exemplo:

- Um utilizador do marketing não deve aceder a documentos de RH via Copilot.

- Executivos podem precisar de acesso mais amplo — mas com políticas DLP mais rigorosas.

Acesso Condicional:

Adicione controlos contextuais:

- Bloquear o uso do Copilot em dispositivos pessoais ou não geridos.

- Exigir MFA para aceder a dados sensíveis.

- Limitar o acesso por localização geográfica ou risco da sessão.

Lembre-se: não se trata apenas de quem pode usar o Copilot, mas do que o Copilot pode usar em nome do utilizador.

3. Defender for Cloud Apps: Monitorize o Comportamento, Não Apenas as Funções

Mesmo com boas políticas de acesso, é necessário monitorizar padrões de uso anormais. O Defender for Cloud Apps introduz uma camada comportamental para detetar riscos em tempo real.

Controlo de Sessão em Tempo Real:

Controle o que o Copilot pode fazer numa sessão ativa. Pode:

- Restringir downloads ou ações de copiar/colar.

- Aplicar modo só de leitura para determinados tipos de documentos.

- Solicitar justificações ao aceder a conteúdos sensíveis.

Deteção de Anomalias:

Configure alertas para:

- Picos súbitos de acesso a ficheiros via Copilot.

- Utilização em horários ou locais invulgares.

- Tentativas de interação com repositórios de conteúdo de alto risco.

Pense nisto como a sua torre de vigilância da IA — detete ameaças antes que escalem.

4. Gestão de Acessos (Entitlement Management): Princípio do Mínimo Privilégio

O acesso ao Teams, SharePoint e OneDrive é frequentemente concedido de forma excessiva e raramente revisto. O Copilot traz essa complexidade à superfície e amplifica-a.

O que fazer:

- Use a Gestão de Acessos do Microsoft Entra ID para controlar o acesso a grupos e apps.

- Execute Revisões de Acesso regularmente para verificar quem tem acesso a quê.

- Revogue acessos desnecessários — especialmente de colaboradores externos e contas inativas.

O Copilot não distingue. Se o utilizador tem acesso, a IA também tem. Limpe antes de ativar.

5. Consentimento de Apps e “Service Principals”: Saiba o que o Copilot Está Autorizado a Fazer

Nos bastidores, o Copilot atua como um “service principal” — uma identidade que pode ter permissões no seu ambiente. Isto significa que pode ser integrado em aplicações, scripts ou serviços de terceiros sem que se aperceba.

Mitigue este risco:

- Reveja as permissões de Apps Empresariais atribuídas ao Copilot e revogue o que for desnecessário.

- Monitorize os registos de consentimento para ver que âmbitos foram autorizados.

- Reduza ou desative as permissões do Graph API do Copilot se o seu caso de uso for limitado.

Confie, mas verifique. Os “service principals” são portas invisíveis — assegure-se de que não estão escancaradas.

⚠️ Destaque: Se Consegue Ver, o Copilot Também Consegue

Um dos aspetos mais mal compreendidos do Copilot é a ideia de que ele “invade” os dados. Não o faz. O Copilot não ignora permissões — limita-se a mostrar conteúdo a que o utilizador já tem acesso.

O que significa que:

- Se um documento sensível for partilhado com “Todos na organização”, o Copilot pode mostrá-lo.

- Se um utilizador pertence a um grupo SharePoint com acesso alargado, o Copilot vai usar esse acesso.

Verifique com atenção:

- As definições de partilha de ficheiros e pastas, especialmente “Qualquer pessoa com o link”.

- As pertenças em equipas e grupos, que podem conceder mais acesso do que o desejado.

- Partilhas de ficheiros pessoais no OneDrive, que muitas vezes passam despercebidas.

O Copilot não cria novos riscos — amplifica os que já existem. Reveja o que está aberto antes que um simples prompt cause uma exposição de dados.

Considerações Finais: Controlo Antes da Capacidade

O Copilot é revolucionário — mas sem medidas de segurança proativas, pode ser uma porta de entrada para exposição de dados, riscos de conformidade e acessos indesejados. A IA não toma decisões — segue regras. O seu trabalho é garantir que essas regras são sólidas.

Antes de deixar o Copilot explorar o seu ambiente digital:

- Classifique e proteja os dados.

- Reveja e limite acessos de forma inteligente.

- Monitorize o comportamento em tempo real.

- Audite permissões regularmente.

Dê ao Copilot as chaves — mas só depois de instalar fechaduras, definir alarmes e traçar um mapa do que pode aceder.

🔒 Para mais informações sobre Dados, Privacidade e Segurança no Microsoft 365 Copilot, consulte o seguinte link: Data, Privacy, and Security for Microsoft 365 Copilot | Microsoft Learn

por Andreia Almeida Lopes, Modern Workplace Specialist na Luza